Name

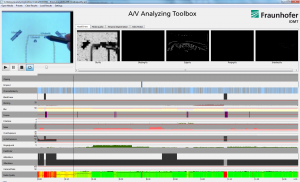

Audiosegmentierung: Automatische Segmentierung von Audiosignalen in homogene Abschnitte (Sprache/Nichtsprache, Musik/Sprache, Sprecherwechsel, …)

Funktionsweise

Das Verfahren und Softwaremodul zur Audiosegmentierung ist in der Lage, eine Audiosignal in homogene Abschnitte zu unterteilen und analog zu einer Videosegmentierung das Audiosignal automatisch zu segmentieren. Nachfolgende Segmente sind möglich:

Sprache/Nichtsprache: Hier wird das Audiosignal in Segmente die Sprache enthalten und Segmente, die keine Sprache enthalten zerlegt. Die Segmentgrenzen und die Klassifikation der Segmente (Sprache oder Nicht/Sprache) sind das Ergebnis der Analyse.Somit lassen sich nur die Segmente ansteuern oder herausfiltern, die Sprache enthalten.

Musik/Sprache: Längere TV- und vor allem Radiosendungen enthalten in der Regel umfangreiche Musikanteile. Diese lassen sich automatisch von den Sprachanteilen trennen. Das Verfahren ist in der Lage, die Segmentgrenzen (Timecode) automatisch zu ermitteln und hinsichtlich Musik und Sprache zu klassifizieren. Bei Bedarf können auch andere wiederkehrende Audioereignisse (z.B. Applaus) detektiert und klassifiziert werden.

Sprecherwechsel: Das Verfahren ist in der Lage eine längere Tonaufnahme in homogene Abschnitte, die zu einem Sprecher gehören, zu unterteilen. Es werden anhand der lokalen Sprecherprofile Übergänge von einem Sprecher zum anderen Sprecher detektiert. Der entsprechende Timecode enthält somit den exakten Zeitpunkt eines Sprecherwechsels.

Sprechergruppierung: Basierend auf den detektierten Sprecherwechselmarken lassen sich die Sprechersegmente in äußerungsspezifische Sprechercluster zusammenführen. Es werden sogenannte SprecherIDs auf Dateiebene vergeben, die die Segmente des gleichen Sprechers auszeichnen. Mittels einer graphischen Umsetzung lassen sich dann der Verlauf der Sprecher in einer Tondatei visualisieren. Eine Erweiterung der Sprechergruppierung stellt die Sprecherkennung dar.

Nutzungspotentiale und Einsatzgebiete

Die Audiosegmentierung wird dazu verwendet, automatisch eine Strukturanalyse eines Tondokumentes (z.B. Radiosendung) durchzuführen. Die automatisch generierten Segmente lassen sich dann nutzen, um schneller in längeren Tondokumenten zu navigieren. Diese Navigationsunterstützung lässt sich im Medienplayer intergrieren.

Referenzprojekte

- WDR – Audiomining: Segmentierung und Transkription von Radiosendungen

Anbieter und Ansprechpartner

- Fraunhofer IAIS (http://www.iais.fraunhofer.de/audiomining.html) – Joachim Köhler (Telefon: 02241 14-1900)

Bilder

Thomas Winkler